براساس گزارش سایت Wired، شرکت گوگل پس از گذشت 3 سال از گلایه کاربران به علت عملکرد الگوریتم نژاد پرستانه اپلیکیشن فوتوز هنوز نتوانسته این مشکل را برطرف سازد. تنها قسمتهایی از سیستم الگوریتم را حذف نموده و به نوعی اَپ را محدود کرده تا از وقوع اتفاقهای مشابه جلوگیری کند.

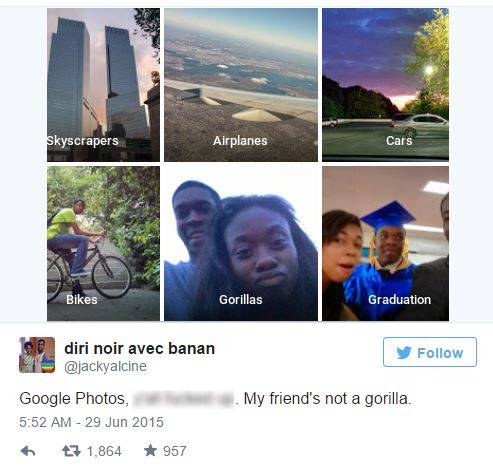

جکی السینی، برنامه نویس سیاه پوست ساکن ایالات متحده آمریکا در هفتم تیر ماه سال 1394 بر حسب اتفاق متوجه شد قابلیت دستهبندی خودکار اپلیکیشن فوتوز شرکت گوگل، تصاویر چهره او و دوستانش را در آلبومی با نام "گوریل ها" قرار داده است.

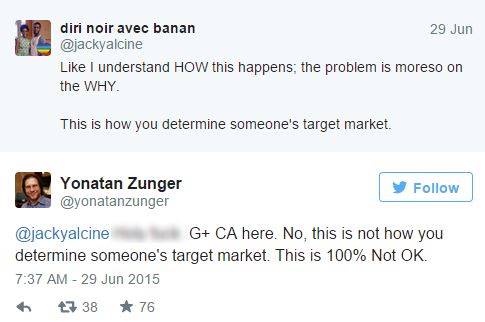

وی بلافاصله در همین رابطه توییتی را خطاب به گوگل ارسال نموده و این پرسش را مطرح کرد که کمپانی ساکن مانتین ویو از چه تصاویر نمونهای برای یادگیری ماشینی الگوریتم های نرم افزارش بهره گرفته که منجر به چنین اشتباه ناخوشایند و توهین آمیزی شده است.

چند روز پیش سایت Wired، پس از گذشت سه سال سعی کرد با انجام آزمایشهایی، الگوریتم نژاد پرستانه فعلی اپلیکشین فوتوز را بسنجد. از این رو دهها هزار تصویر از گونههای مختلف میمون و گوریل در این اَپ بارگذاری نمود و متوجه شد که دستهبندی گوریل و شامپانزه در الگوریتم گوگل وجود ندارد.

این سایت حتی متوجه شد جستجوی لغات مرد سیاه (black man) و زن سیاه (black woman)، عکسهایی از زن و مردهایی با لباس سیاه را نتیجه میدهد. از این هنوز دستهبندی با رنگ پوست مشخص در این اپ وجود ندارد.

به گفتهی سخنگوی شرکت گوگل، کلمات gorilla (گوریل)، monkey (میمون)، chimp و chimpanzee (شامپانزه) در گوگل فوتوز از سال 2015 تا به حال مسدود بودهاند. اگرچه این دسته بندی ها البته همچنان در دیگر سرویس های گوگل از جمله Cloud Vision API که به شرکت های دیگر فروخته می شوند، موجودند.

عجیب است شرکت گوگل که از پیشگامان هوش مصتوعی تجاری است نتوانسته پس از 3 سال راهحل کاملی برای این مشکل بیابد و نشان میدهد که تعلیم یک نرمافزار هوش مصنوعی میتواند تا چه حد مشکل باشد. مخصوصاً اگر توسط گروههایی با تنوع نژادی بالا امتحان نشده باشد.

هنوز مشخص نیست که گوگل چرا این مسئله را رفع نکرده. آیا نتوانسته یا نخواسته که منابعی به این مشکل اختصاص دهد. شاید هم از بوجود آمدن اتفاقاتی مشابه ترسیده است اما مشخصاً سیلیکون ولی به راه حلهای جامع و کاملی در این گونه مشکلات هوش مصنوعی بیشتر از تعمیرات کوتاه مدت نیاز دارد.