فرادید؛ در جریان خطرات و بحرانهایی که بشریت

را تهدید میکنند، معمولاً نسلهای آینده را فراموش میکنیم. نسلهایی که

امیدواریم پس از ما باقی بمانند. از کلمه "امید" استفاده میکنم زیرا

بشر با "خطرات وجودی" مواجه است، خطراتی که نسل بشر را منقرض خواهند

کرد.

به گزارش فرادید؛ با اینحال این خطرات هنوز بهاندازه کافی و

مطلوب موردمطالعه قرار نگرفتهاند. مردم هزاران سال است که از پایان دنیا حرف میزنند،

اما تعداد کمی تلاش کردهاند از وقوع آن جلوگیری کنند. در قرن گذشته، خطرات جدیدی

را کشف یا ایجاد کردهایم. به پنج مورد از جدیترین خطرات که بقای بشر را تهدید میکنند،

میپردازیم:

1. جنگ هستهای

بااینکه تا به امروز تنها از دو سلاح هستهای استفادهشده

(در هیروشیما و ناگازاکی در جنگ جهانی دوم)، اما اشتباه است که جنگ هستهای را

غیرممکن در نظر بگیریم.

بحران موشکی کوبا تا یک قدمی جنگ هستهای پیش

رفت. متأسفانه بحران موشکی کوبا معروفترین مورد بود. تاریخ بازدارندگی هستهای

میان شوروی و آمریکا نیز پر از اشتباهات خطرناک است.

یک جنگ هستهای تمامعیار میان دو کشور قدرتمند

صدها میلیون نفر را بهطور مستقیم یا غیرمستقیم میکشد. اما این بهتنهایی یک خطر وجودی

نیست. انفجار اتمی در سطح محلی کشنده خواهند بود، اما مشکلاتی که در سطح جهانی

ایجاد میکند نسبتاً محدود است.

خطر اصلی زمستان هستهای است. دودههای حاصل از

انفجار وارد استراتوسفر شده و سبب کاهش دما و خشکی زمین میشود. این تغییر آب و

هوایی کشاورزی را در اکثر نقاط جهان متوقف خواهد کرد. در این صورت میلیاردها نفر

خواهند مرد و بازماندگان نیز با عوامل دیگری مانند بیماری جان خواهند سپرد.

2. بیوتروریسمِ جهانی

در طول تاریخ، بیماریهای همهگیر نسبت به جنگ

تلفات بیشتری داشتهاند. به این نوع بیماریهای "پاندمی" گفته میشود.

پاندمی های طبیعی تهدید وجودی محسوب نمیشوند. اما متأسفانه ما بیماریها را بدتر میکنیم.

یکی از نمونههای معروف واردکردن یک زن اضافی در موش صحرایی بود که آن را خطرناکتر

کرد، بهطوریکه میتوانست افراد واکسینه شده را نیز آلوده کند. تحقیقات اخیر در

آنفولانزای مرغی نشان داد که میتوان میزان واگیردار بودن بیماری را افزایش داد.

در حال حاضر احتمال اینکه چنین ویروسی از عمد

منتشر شود، بسیار کم است. اما بیوتکنولوژی روزبهروز ارزانتر و بهتر میشود و گروههای

بیشتری موفق به تشدید قدرت بیماریها میشوند.

بیشتر تحقیقات درزمینهٔ سلاحهای بیولوژیک توسط دولتهایی

صورت گرفته که قصد دارند ابزاری کنترلکننده در اختیار داشته باشند. اما گروههایی

هم هستند که اهداف دیگری دارند. برای مثال فرقه "اوم شینریکیو" سعی کرد با

پخش گاز سارین در متروی توکیو رسیدن آخرالزمان را تسریع کند. برخی فرقهها معتقدند

زمین باید از سکونت بشر خالی شود.

با توجه به ارقام و آمار موجود، خطر وقوع

بیوتروریسم بسیار پایین به نظر میرسد. اما دولتها با این ابزار بیشتر از تروریستها

آدم کشتهاند. در جنگ جهانی دوم بیش از 400 هزار نفر در ژاپن براثر جنگ بیولوژیک

کشته شدند.

3. هوش مصنوعی

هوش قدرت بسیار بالایی است. با توانایی حل مسئله

و هماهنگی گروهی توانستیم از دیگر موجودات

پیشی بگیریم. اکنون بقای آنها به تصمیمات انسان بستگی دارد، نه کاری که خودشان

انجام میدهند. باهوش بودن مزیتی والا برای انسان و سازمانها است. به همین دلیل تلاشهای

زیادی برای یافتن شیوههای بهبود هوش جمعی و فردی میشود: از داروهای افزایش

شناختی تا نرمافزارهای هوش مصنوعی.

مشکل اینجاست که نهادهای هوشمند در دستیابی به

اهدافشان بسیار خوب هستند، اما اگر این اهداف بهدرستی تنظیم نشوند، نتایج فاجعهآمیزی

به بار خواهد آمد. هوش بهخودیخود خوب و اخلاقی رفتار نمیکند. در حقیقت، میتوان

ثابت کرد که انواع خاصی از سیستمهای فوق هوشمند از قوانین اخلاقی پیروی نمیکنند، حتی

اگر درست باشند.

در تلاش برای توضیح مسائل به هوش مصنوعی، به

مشکلات عمیق فلسفی میرسیم. ارزشهای انسانی پراکنده و پیچیده هستند و ما در ابراز

آنها مهارت نداریم و نمیتوانیم تمام جوانب آنها را بررسی کنیم.

هوش نرمافزاری خیلی سریع از سطح پایینتر از

انسان، به سطحی فوقالعاده قدرتمند میرسد. گفته میشود زمانی که نرمافزار آنقدر

خوب شود که بتواند نرمافزارهای بهتری ایجاد کند، احتمالِ "انفجار هوش"

وجود خواهد داشت. اگر چنین جهشی رخ دهد، اختلاف زیادی در قدرت بالقوه میان سیستم

هوشمند (یا افرادی که به آن دستور میدهند) و سایر نقاط جهان به وجود خواهد آمد. اگر

اهداف بهخوبی پایهگذاری نشده باشند، باید منتظر فاجعه باشیم.

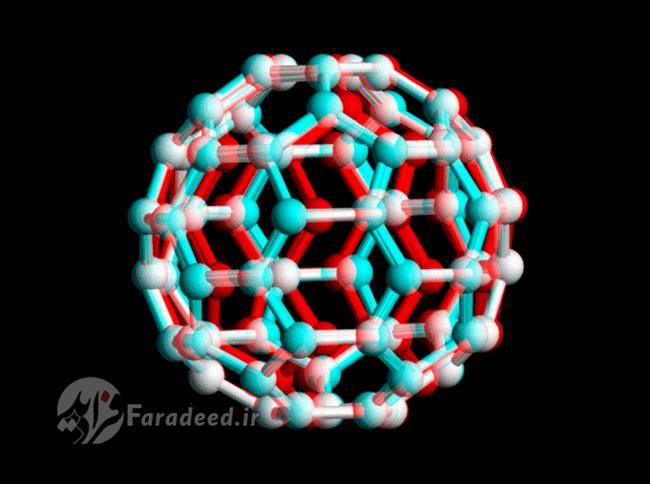

4. فناوری نانو

فناوری نانو کنترل بر موارد با دقت اتمی و

مولکولی است. این بهخودیخود خطرناک نیست، بلکه در اکثر زمینهها خبر خوبی محسوب میشود.

ما مشکل اینجاست که درست همانند بیوتکنولوژی، افزایش قدرت احتمال سوءاستفاده از آن

را افزایش میدهد و ممانعت از آن کار آسانی نخواهد بود.

مشکل بزرگ "غول خاکستری" حاصل از نانو

ماشینها نیست که همهچیز را میخورند. برای این هدف طراحی هوشمندانه لازم است.

شاید بالاخره یک فرد دیوانه موفق به طراحی آن شود. اما خطرات مخرب دیگری هم وجود

دارند که باید نگرانشان باشیم.

بزرگترین خطر ایدئال بودن تولیدات دقیق اتمی

برای ساخت سریع و ارزانِ سلاح است. در جهانی که هر کشوری میتواند مقدار زیادی

سلاح تولید کند، رقابت در دستیابی به سلاحهای برتر ممکن است از کنترل خارج شود.

نمیتوانیم احتمال خطر وجودی را از نانو فناوریِ

آینده پیشبینی کنیم، اما میتوان گفت که بسیار مخرب و ناخوشایند خواهد بود، زیرا

هرچه بخواهیم را به ما میدهد.

5. ناشناختههای نامعلوم

آزاردهندهترین احتمال این است که عامل مرگباری در جهان وجود داشته باشد و ما از آن بیخبر باشیم. خطر هرچه که باشد، برای اینکه

نسل بشر را تهدید کند باید تقریباً اجتنابناپذیر باشد. ما از چنین چیزی اطلاع

نداریم، اما ممکن است وجود داشته باشد.

ترجمه: وبسایت فرادید